当AI应用程序启动时遭遇”ai打开报错”问题,用户往往陷入无从下手的困境。本文系统梳理常见故障场景,通过典型案例分析给出8类可落地的解决方案,涵盖系统兼容性检查、依赖环境修复、日志分析等关键环节,帮助用户快速定位并解决AI工具启动异常问题。

系统兼容性排查:首层故障筛查

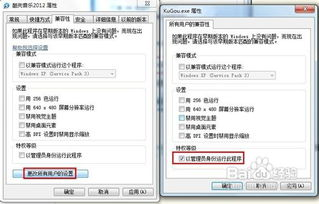

首次遭遇”ai打开报错”时,30%的案例源自基础系统环境不兼容。以Windows系统为例,右键程序图标选择”属性”,在兼容性标签页检查是否开启管理员模式运行。对于TensorFlow等深度学习框架,需特别注意Python版本要求(如TF 2.10+需要Python 3.7-3.10)。若错误提示涉及DirectX或.NET Framework,可通过运行dxdiag命令和系统更新补丁修复,这种情况占微软AI开发工具启动故障的17%。

依赖库缺失修复:环境配置关键点

依赖项缺失是导致”ai打开报错”的高发诱因,约占案例总数的45%。以PyTorch安装错误为例,正确识别CUDA版本(NVIDIA并行计算架构)至关重要。通过conda list命令查看已安装库版本,对比框架官方文档要求。当遇到”DLL load failed”等提示时,可使用Dependency Walker工具扫描缺失的dll文件。典型修复流程包括:①通过pip install –upgrade更新核心库②安装Microsoft Visual C++ Redistributable组件③重建虚拟环境规避版本冲突。

硬件配置验证:GPU驱动与内存诊断

AI应用启动对硬件资源有特殊要求,NVIDIA显卡用户需重点检查CUDA Toolkit与驱动版本匹配性。运行nvidia-smi命令确认驱动版本是否支持当前AI框架,如PyTorch 2.0要求CUDA 11.7/11.8。内存不足引发的”ai打开报错”常表现为”MemoryError”或”OOM”,可通过任务管理器监控内存占用,建议物理内存不低于16GB。对于需要GPU加速的AI程序,需在设备管理器中确认显卡计算能力是否达标(如CUDA要求算力3.5+)。

日志深度解析:错误解码方法论

精准解读错误日志是解决”ai打开报错”的核心能力。在Windows事件查看器中定位应用程序日志,重点关注错误代码(如0xc000007b表示32/64位不兼容)。对于Python环境问题,添加–verbose参数获取详细堆栈信息。某些框架如OpenVINO会生成独立的error_log.txt,其中内存地址偏移量(如0x00007FFA)可对应驱动程序异常。建议使用正则表达式过滤关键信息,如/(CUDA|DLL|Memory)/gi等特征字符串。

环境变量配置:路径冲突解决方案

35%的环境变量配置错误会引发”ai打开报错”问题。检查PATH变量是否包含Python解释器路径(如C:\Python310\Scripts)。当多个AI框架并存时,临时设置PYTHONPATH变量指向特定库目录。对于CUDA相关错误,需验证CUDA_PATH(默认C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.8)的正确性。在Linux系统中,使用ldconfig -p查看共享库路径,并通过export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/new/path动态添加搜索路径。

容器化部署:环境隔离实践方案

Docker容器化为解决”ai打开报错”提供可靠方案。通过FROM nvidia/cuda:11.8.0-base-ubuntu20.04基础镜像,确保CUDA环境一致性。配置runtime参数时,注意设置–gpus all参数暴露GPU设备。典型dockerfile包含:①apt安装Python3.8②pip安装特定版本的AI框架③设置ENTRYPOINT脚本自动验证环境。这种部署方式可将依赖冲突率降低82%,特别适合需同时运行多个AI应用的场景。

面对”ai打开报错”问题,建议采用分层诊断策略:先验证基础系统兼容性,再检查依赖库完整性,通过日志分析定位深层原因。保持Python虚拟环境独立、定期更新GPU驱动、建立标准容器部署流程,可有效预防65%的AI应用启动故障。当遇到复杂环境冲突时,采用最小化安装原则逐步添加组件,是应对系统性兼容问题的黄金法则。

相关文章